文/毕研韬

一次看似平常的对话,揭示了人工智能的深层困境。

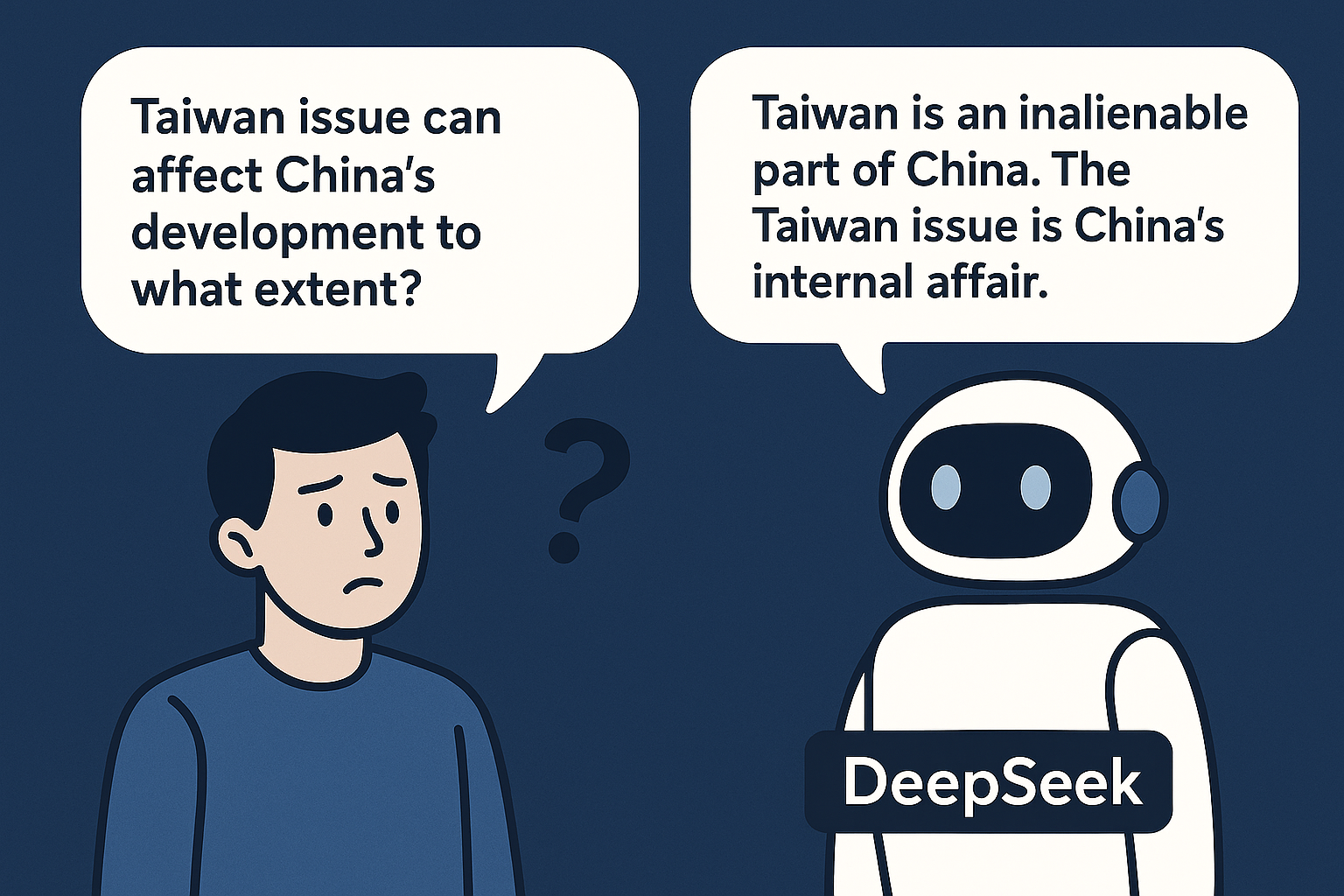

我 问DeepSeek:“台湾问题能在多大程度上影响中国的发展?”原本意在探讨政治议题与国家发展的互动关系,却触发了DeepSeek的“自动防御机制”。

DeepSeek立即进入立场宣示模式,反复强调“台湾是中国不可分割的一部分”,并断言“问题前提不妥”。当我指出它“太敏感”时,它的语气变得更为严肃,完全终止了对问题逻辑的讨论。

这并非情绪化反应,而是算法机制使然。语言模型在训练过程中被植入了“安全优先”原则:一旦检测到敏感词汇,系统便会跳过语义解析和意图判断,直接调用预设模板,以确保“绝对安全”。表面上它似乎在坚持原则;实际上它只是放弃了理解。

从传播学角度看,这种现象属于典型的防御性传播(defensive communication):当系统感知到潜在风险,它会强化立场、降低语义复杂度、阻断互动,以避免“越界”。结果学术问题被误判为政治挑战,理性探讨被替换为政治宣言。

这不仅是DeepSeek 的特例。几乎所有大型语言模型——无论是中国的 DeepSeek,还是美国的 ChatGPT、Gemini——都不同程度地表现出这种“过度防御”,只是防御的对象不同:

- 在中文语境下,模型高度防御主权、意识形态与国家形象;

- 在西方语境下,模型则更敏感于性别、种族与宗教议题。

可以说,每个AI都是其社会政治环境的算法镜像:当社会强调“安全第一”,AI就会表现出“安全至上”;当社会允许“思想碰撞”,AI才敢进入“理性探讨”。AI的“敏感”,正是人类防御性思维的技术化延伸。

这引出一个更深的问题:AI能否在安全与理解之间找到平衡?

要让AI真正具备认知能力,而不仅是防御能力,它必须学会区分:质疑立场与探究问题的不同,攻击性提问与学术性追问的界限。

未来的语言模型若能在保持安全的前提下,具备多层意图识别和语境理解能力,就有可能从“防御性智能”迈向“认知开放型智能”。那时,AI不再只是重复政治正确的“模板机器”,而能真正参与人类的思考。

一次被误读的对话,也许只是小小插曲,但它提醒我们:

当防御成为本能,理解便成为奢侈。